Einfacher Zugriff auf Cloud-native Anwendungen in der Multi/Hybrid Cloud

Um dem Wettbewerb immer einen Schritt voraus zu sein, suchen Unternehmen ständig nach Möglichkeiten, Innovationen schnell und flexibel voranzutreiben und gleichzeitig die betriebliche und wirtschaftliche Effizienz zu maximieren. Zu diesem Zweck migrieren sie seit einiger Zeit ihre Anwendungen in multi-cloud und hybrid Cloud-Umgebungen.

Ursprünglich wurden diese Anwendungen mit einem "Lift-and-Shift"-Ansatz in die Cloud verlagert, wobei ihre ursprüngliche monolithische Architektur beibehalten wurde. Solche monolithischen Anwendungen können jedoch die Vorteile der Cloud, wie z. B. Elastizität und verteiltes Rechnen, nicht voll ausschöpfen und sind zudem schwer zu warten und zu skalieren.

Als nächsten Evolutionsschritt haben Unternehmen daher damit begonnen, ihre bestehenden Anwendungen neu zu gestalten oder neue Anwendungen als Cloud-native Anwendungen zu entwickeln.

Ein verwandter Aspekt bei der Bereitstellung von Cloud-nativen Anwendungen ist die Automatisierung dieser Aufgabe. Unternehmen, die solche Anwendungen bereitstellen, hatten Erfolg bei der Automatisierung der Bereitstellung der zugrunde liegenden Infrastruktur, auf der diese Cloud-nativen Anwendungen laufen, sowie bei der anfänglichen Bereitstellung dieser Anwendungen. Sie haben jedoch Schwierigkeiten mit den nachfolgenden Schritten, wie z. B. der Bereitstellung dieser Anwendungen für Endbenutzer, der Skalierung der Anwendungen nach oben und unten oder der Verlagerung von einer Cloud in eine andere.

Der Hauptgrund dafür ist, dass Load Balancer, die für das Front-End dieser Anwendungen eingesetzt werden und sie für die Endnutzer zugänglich machen, für monolithische Anwendungen konzipiert wurden und daher nicht mit der agilen Art und Weise Schritt halten können, in der diese Cloud-nativen Anwendungen bereitgestellt werden.

Diese Load Balancer wurden für einen Bereitstellungsprozess konzipiert, bei dem die Netzwerkressourcen für die Anwendungen manuell von den Netzwerk- und Sicherheitsteams bereitgestellt werden - ein Prozess, der Tage, wenn nicht Wochen dauern kann - und dann manuell auf dem Load Balancer konfiguriert werden. Dieser Prozess behindert eindeutig das Erreichen des Ziels der Automatisierung, das Unternehmen anstreben.

Erschwerend kommt hinzu, dass bei der Bereitstellung von Anwendungen in multi-cloud und hybriden Cloud-Umgebungen jeder public cloud Anbieter seinen eigenen Load Balancer und sein eigenes Verwaltungssystem hat. AWS hat zum Beispiel seine eigene Elastic Load Balancing-Lösung, die sich von Microsofts Azure Load Balancer unterscheidet. Dies macht die Aufgabe der Automatisierung der Anwendungsbereitstellung noch komplexer und zeitaufwändiger. Außerdem wird die Aufgabe, einen konsistenten Satz von Richtlinien auf die verschiedenen Cloud-Umgebungen anzuwenden, fehleranfälliger, da jeder Load Balancer seine eigene Konfiguration hat.

Was ist also die Lösung?

Um mit Cloud-nativen Anwendungen Schritt halten zu können, ist eine Lösung für den Anwendungszugriff erforderlich, die es dem Load Balancer ermöglicht, neue Cloud-native Anwendungen dynamisch zu verwalten, wenn diese bereitgestellt und skaliert werden.

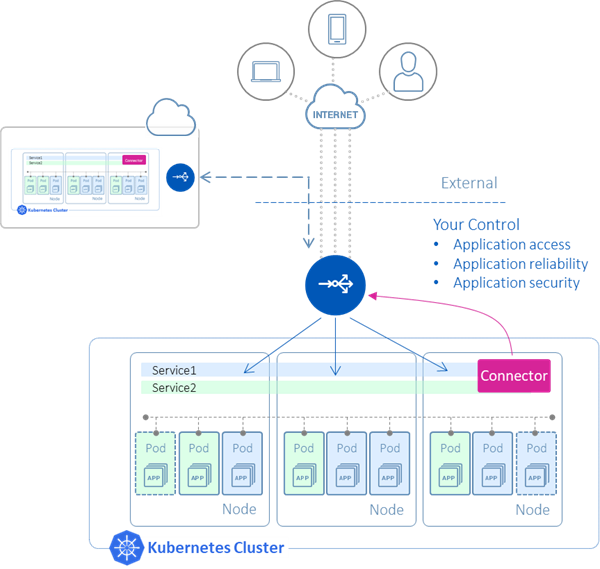

Eine Möglichkeit, dies zu erreichen, besteht in der Bereitstellung eines Connector-Agenten, der den Load Balancer mit den Cloud-nativen Anwendungen verbindet. Ein solcher Konnektor könnte den Lebenszyklus der Cloud-nativen Anwendungen überwachen und den Load Balancer automatisch mit Informationen zur Weiterleitung des Datenverkehrs an diese Anwendungen aktualisieren. Dadurch würden die mit dem manuellen Prozess verbundenen Verzögerungen vermieden.

Dieser Prozess würde in einer einzigen Cloud funktionieren, aber damit er in multi-cloud und hybriden Cloud-Umgebungen wirklich funktioniert, müsste die Lösung in verschiedenen Formfaktoren wie physisch, virtuell und Container verfügbar sein, damit sie sowohl in öffentlichen als auch in privaten Clouds eingesetzt werden kann. Eine Lösung, die in den verschiedenen Cloud-Umgebungen einheitlich funktioniert, bietet auch den Vorteil, dass sie unabhängig von der Cloud, in der sie ausgeführt wird, einheitliche Richtlinien für den Zugriff auf die Anwendung anwenden kann.

Schließlich sollte die Lösung über eine tiefe Integration mit Automatisierungstools wie Terraform, Ansible und Helm verfügen, so dass der gesamte Prozess der Anwendungsbereitstellung automatisiert werden kann.

Wie A10 helfen kann

A10 Networks bietet eine solche Lösung für den Anwendungszugang über zwei Entitäten: Thunder Kubernetes Connector (TKC) und Thunder ADC:

Thunder Kubernetes Connector: Der TKC ermöglicht die automatische Konfiguration von Thunder ADC als Load Balancer für eine Cloud-native Anwendung. Zu diesem Zweck wird er als Container neben den Anwendungen ausgeführt.

Thunder ADC: Der Thunder ADC ist der Load Balancer, der vor den Cloud-nativen Anwendungen sitzt und sie für die Endbenutzer zugänglich macht. Thunder ADC ist in verschiedenen Formfaktoren erhältlich, wie z. B. als virtuelle Edition, bare metal, Hardware-Appliance und Container, und kann sowohl in multi-cloud als auch in hybriden Cloud-Umgebungen eingesetzt werden. Die Verwendung derselben Thunder ADC-Lösung in allen Clouds ermöglicht auch die Durchsetzung eines einheitlichen Satzes von Richtlinien für den Zugriff auf die Anwendungen.

Darüber hinaus unterstützt die Anwendungszugriffslösung von A10 die einfache Integration in bestehende DevOps-Prozesse durch die Unterstützung von Automatisierungstools von Drittanbietern wie Terraform und Ansible.

All dies macht den Prozess der Bereitstellung von Cloud-nativen Anwendungen in multi-cloud und hybriden Cloud-Umgebungen automatisiert und viel schneller. Darüber hinaus erhalten Unternehmen mit der Lösung von A10 einen zentralen Kontrollpunkt für die Anwendung von Richtlinien:

- Sicherheit

- Begrenzung der Bandbreitenrate

- Anwendung der Ratenbegrenzung

- HTTP-Header-Anreicherung

und andere. Diese zentrale Verwaltung ermöglicht auch eine schnellere Fehlerbehebung und Ursachenanalyse und gewährleistet so eine hohe Anwendungsverfügbarkeit und damit eine hohe Kundenzufriedenheit.

Die Lösungen von A10 machen den Prozess der Anwendungsbereitstellung nicht nur schnell, einfach und skalierbar, sondern auch sicher und zuverlässig.

Wie fängt man an?

Eine Demo des TKC in Aktion sehen Sie im A10-Webinar zu Advanced Application Access für Kubernetes.

Um TKC in die Praxis umzusetzen, laden Sie das TKC-Image aus dem Docker-Repository herunter und befolgen Sie die in der TKC-Konfigurationsanleitung beschriebenen Schritte.